作者:崔康吉,余亮(广东科技学院,广东东莞523083)

摘要:随着数据中心能耗的急剧增长,使之成为双碳目标达成的重点监控目标。文章针对数据中心中功耗大于200W的高功率芯片,沿着散热路径,采用液冷散热技术,经过液冷冷板、机架级液冷、机房级CDU液冷工质分配系统与精密空调的协同工作,使用液冷工质取代空气作为传热介质,有效提升了散热效率,数据中心散热系统的能耗占比从现在的37%降低到了10%左右,节能减碳效果非常明显。

关键词:能耗;热量;液冷;冷板;液冷分配单元

中图分类号:TP391文献标识码:B文章编号:2096-9759(2022)08-011603

Design of High Efficiency Liquid Cooling System in the Datacenter

CUI Kangji, YU Liang(Guangdong University of Science and Technology, Dongguan 523083, China)

Abstract:The energy consumption of datacenter swhich increase sharply has become a key monitoring target for achieving car?bon peaking and carbon neutrality goals. This paper is aimed at the high power consumption chipwith more than 200W, through the use of liquid cooling technology, along the heat dissipation path, through the liquid coldplate, racklevel liquid cooling, cabi?net level coolant distribution unit system, liquid coolant working fluid instead of air as a heat transfer medium, effectivelyim?prove the heat dissipation efficiency, energy consumption of the data center from the current 37% to about 10%,the effect of energy conservation and emission reduction is obviously.

Keywords:Energy consumption; Heat; Liquid Cooling; ColdPlate; CDU

0 引言

人工智能、5G通信、网上购物、手机支付、健康扫码等数字经济的加速应用,背后有配套的数据中心作为支撑。随着数字经济的发展,我国数据中心整体用电量飞速增长,在2015年大型数据中心的耗电量为1000亿千瓦时,到了2020年,耗电量达到了2000亿千瓦时,5年的时间翻了一番,相当于2个三峡大坝的发电量,约占全社会用电量的2.7%叫成为重点监控的高能耗行业。2021年10月18日,国家发展改革委印发《关于严格能效约束推动重点领域节能降碳的若干意见》,推动重点工业领域节能降碳和绿色转型,坚决遏制全国“两高”项目盲目发展,确保如期实现碳达峰目标,要求到2025年,数据中心达到标杆水平的产能比例超过30%;到2030年,行业整体能效水平和碳排放强度达到国际先进水平,为如期实现碳达峰目标提供有力支撑。

在数据中心中,影响能耗的主要因素是:IT设备、散热系统、供电系统等,其中rr设备占数据中心总能耗的50%,散热系统占总能耗的37%,IT设备的能耗属于基础能耗,短时间很难明显降低;散热系统的能耗降低与高效运行成为节能降耗的首选目标。

1 数据中心散热系统的构成

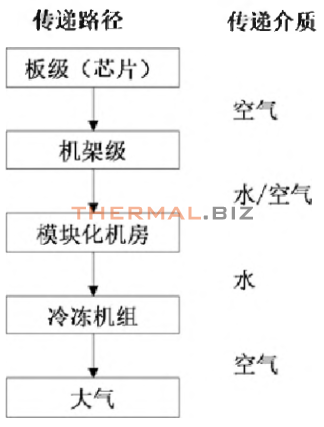

设备所消耗的电能大部分会转变为废热,为了让it设备在合适的工作温度下正常运转,数据中心配置了冷水机组、冷却塔、精密空调等设备的制冷与散热系统叫将废热排出数据中心,传热过程如图1所示。其中冷水机组、冷却塔、水泵、精密空调是能耗关注的重点。

图1数据中心热量传递图

当前数据中心的传热介质基本上为:空气或者水。其中水的定压比热容为1.0(MkJ7(KgK),水的比热容为4200kJ7(KgK)B',水的带热能力是空气的1000倍左右。因此在散热系统的设计中,采用水作为散热介质是一种有效的节能手段。为了提升制冷系统的能效,在热量采集侧,采用高效散热器与精确送凤等手段,将热量传递出来;在精密空调侧,从房间级制冷发展到模块化机房、机架级制冷,更加靠近热源,减少冷媒输送过程的能耗;在冷源制备环节,从风冷向水冷、自然冷却发展,提升外部热量传递效率。

传统散热系统中精密空调、冷机、冷却塔为具有各自的控制系统与运行策略,效率优化在局部运行,单体已经做到最优,但在整体上散热效率还需要进一步提升。

要系统性的改善散热效率,需要从热量采集、冷源制备、外部热量传递等端到端进行协同管理和精细化控制,从而降低散热系统的功耗。

2 端到端的液冷散热系统设计

2.1板级液冷散热设计

随着算力需求的大爆发,CPU与GPU的集成度与功耗均出现了指数级增长,单芯片功耗已经攀升到了300W,传统的芯片散热器与风冷散热方案遇到了散热瓶颈。

芯片是热量的源头,如何将芯片内部的热量带出来,是数据中心散热系统解决的首要问题。从散热路径上看,芯片发出的热量首先需要经过芯片内部传递到板级散热器,更加高效的散热器方案会更加有利于热量的收集与采集。

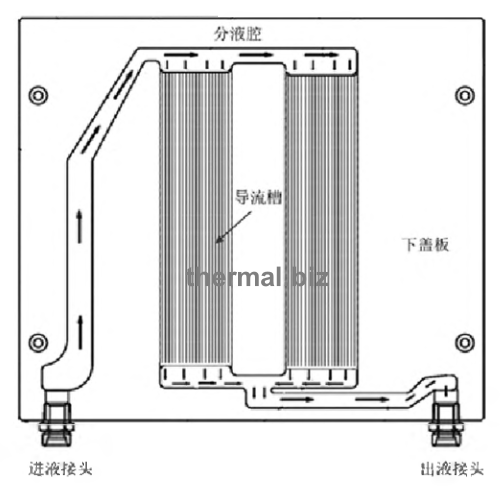

对于功耗低于200W的单芯片,单机架功耗小于20kW的rr设备配置叫可以继续使用空气作为传热介质,采用热管散热器与VC散热器,配套使用高传导系数的?材料(比如石墨片/石墨烯等),有效地减少了芯片与散热器基板之间扩散热阻问题,提高散热器的散热效率。对于功耗大于200W的单芯片,单机架功耗大于20kW的IT设备配置叫继续使用空气作为传热介质,芯片的热量已经无法传递传来,需要使用液体工质进行散热。液冷冷板散热是目前比较成熟的板级芯片散热技术。液冷冷板包括进液接头、出液接头、上盖板与底板,上盖板与底板之间通过真空钎焊工艺连接起来,形成密封的液体换热腔体,腔体内部根据芯片的位置与散热需求设置分液腔与不同宽度的导流沟槽,实现液体流动的节流控制与增加扰流,增强冷板的局部散热能彳,消除高功率芯片造成的热点散热瓶颈,内部构造如图2所示。

图2液冷冷板的剖面图

在同一个机架中存在不同种类的单板,其功率与热点是不一样的,但是供液管路在进液接头处的供液压力基本相同,因此需要通冷板的分液腔进行节流控制。对于芯片功耗比较低的单板,采用节流控制,减少工质的流量供应。液冷散热的冷板在实际设计时,覆盖了的CPU、内存与其他高功率器件,但还有电阻、电容等大多数器件没有覆盖,就会产生少量余热,需要通过凤扇进行散热,导致在系统中液冷散热与空气散热并存,散热效率还有提升的空间。冷板设计时,通过TIM材料与所有器件实现搭接覆盖,在技术上可以实现100沁冷散热,冷板的成本与复杂度随之增加。在追求高效散热的同时,还要综合考虑初始成本的投入。如果节点单板的种类单一,可以考虑使用全覆盖的单板,初始成本可以通过发货量的提升带来成本降低的抵冲,从而实现节能降碳与投入的平衡。

对于冷板式散热而言,采用液体工质通常为去离子水,比热容高,能够快速吸收热量,同时可以做到无腐蚀性,对管路的可靠性无影响。冷板液冷散热属于间接式液冷,芯片与液态工质不直接接触,可靠性高,技术成熟。但是在芯片与液态工质之间存在热阻,因此部分厂家在推广浸没式液冷方案。设备浸没在液体里循环冷却,芯片与液冷工质直接接触,减少了热阻,同时利用工质相变过程带走更多的热量,成为液冷散热中的新热点。浸没式液冷最常使用的工质为氟化液,目前工质的成本比较高,成为大规模商用的障碍。

2.2机架级液冷散热

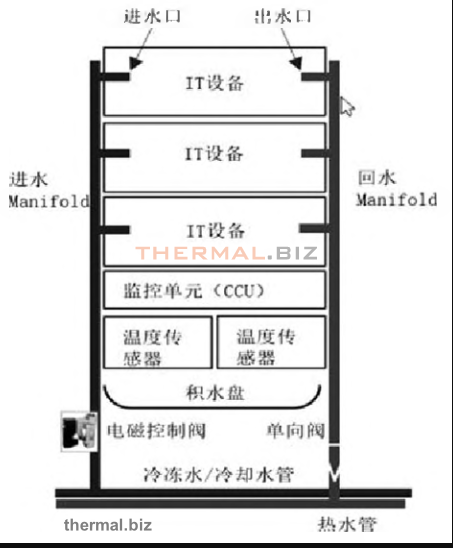

在数据中心中,IT设备是以机架为单位进行布置。机架用于容纳数据中心的信息设备,比如:服务器、存储器、网络交换机等。板级散热将单个IT设备的热量带出来,还需要整机架将热量汇集并传递到室外。在机架级液冷散热中,主要组成部分包括进出水Manifold、监控单元、温度传感器、电磁阀与单向阀等,如图3所示。

图3机架级液冷配置图

进出水Manifold对外连接到机房级的液冷分配单元,对内通过快接头连接到液冷冷板的进液接头与出液接头,系统热量通过Manifold传递到机架外侧。

电磁阀与单向阀的主要功能是用于控制液体的流动,防止出现漏液时故障范围控制在单个机架内。

温度传感器的主要作用实时检测进出水温度,利用进出水的温度差,对电磁阀门开度进行控制,实现对进出水流量的控制,确保热量与流量相匹配。

液冷系统采用的工质为去离子水,理论上不会造成短路,但是电路板或电子部件往往有灰尘颗粒杂志,去离子水接触电路板后会造成短路,这也是液冷散热在实施中遇到的最大阻力与疑惑。对于冷板泄露问题,需要从质量骨控、微量泄露监控、突发大量泄露预防等手段进行控制。质量管控分为生产环节与安装应用环节。在生产环节,确保工艺可靠,100%冷板进行保压测试,使用超声波进行抽检探伤;快速插拔接头要进行有效磁次数与长期可靠性验证。在安装应用环节,要确保二次管路在安装之前冲洗干净,防止杂质颗粒造成快接头堵塞、弹簧卡顿、橡胶圈失效等故障隐患,从而在运行中造成泄露,上述的手段与措施主要是用于保证尽可能不发生泄露。

如果冷板发生了微量泄露,需要能够实现检测并告警,提示维护人员尽快维修。检测方法包括两种:一种是采用水浸传感器检测,水浸传感器安装在积水盘上。积水盘的主要作用是出现漏液时,便于漏液检测,同时防止液体泄漏到机架外,减少故障扩散。水浸传感器检测成熟可靠,但需要等到泄露的工质沿着硬件单板与机架安装件汇集到积水盘,此时泄露工质的总量已经很多大,在流动的过程中可能已经造成单板与器件损坏。另外一种就是实时监测。在工质中混入沸点较低的示踪物质,当发生泄露时,通过单板内置的气体传感器进行检测。对于突发的大量泄露,概率比较低,但影响很大,在机架级Manifold进出水管路入口处增加单向阀,当出现较大压力差时单向关闭。

2.3机房级液冷散热设计

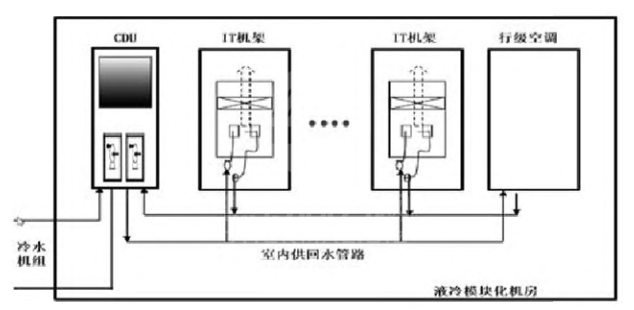

机房级散热就是要将机架传出来的热量传递到室外。机房级液冷方案包括液冷模块化机房、冷水机组、水泵、冷却塔、管路等,如图4所示。

图4机房级液冷配置图

通常情况下,一个液冷模块机房内部包活2个备份的液冷分配单元CDU、10-20个U机架、1-2个行级空调、供配电设备,如图4所不。

液冷分配单元CDU用于进行液冷机架间的液体工M分配系统,提供二次侧流量分配、压力控制、物理隔离、防凝露等功能。在实腿行中,cdu提供-定Mfi、一定的冷却水进Arr液冷卿,融Mhnifeid臥液冷冷板,带走处理器与轴部件发出的热量,被加热的冷却水回流到cdu的中间换热单元,将热量澤放到室外回水骨路中,该部分热量再通过冷水机组或者干冷器排放带到室外环境中,完成对液冷服务器的热量管理。

液冷分配单元CDU通过调节送入液冷冷板的工质温度与流量从而向IT机架提供好,起到冷量分配的作用,内部的换热单元也起到模块化机房与室外的供液回路的隔离的作用。CDU的作用非常关键,因此通常采用1+1备份。CDU对于液态工质的流量控制,是通过检测进出水温度与供液压力,控制供液水泵的转速完成。目前大多数的CDU控制系统并没有实现与机架内的温度检测联动,因此在控制上相对粗放。为了解决上述问题,部分应用将集中供液的CDU改为分布式CDU,CDU内置到机架中,这样CDU的流量调节就完全依照机架内的业务运行状态与功耗波动。集中式CDU适合于液冷散热的机架数量多,可以整合成一个模块化机房的情况;分布式CDU适合于液冷散热的机架数量只有2-3个,方便部署。

3 结语

在双碳目标的牵引下,数据中心承载着双重使命:一方面通过集约化与规模化的运作,为数字经济提供充足的算力。在数据中心算力效能的牵引下,高密度机架与高功耗芯片的普遍应用,使传统的风冷散热遇到了瓶颈;另一方面借助高效散热器液、液冷散热、干冷器自然冷源等多种技术,降低自身的能耗。采用了液冷散热之后,散热效率显著提升国散热系统能耗占比从37%降低到了10%左右,节能减碳效果非常明显;如果全国50%的新建数据中心采用液冷散热形式建设,每年可以节省450亿度电,减排3000万吨二氧化碳。

參考文献:

[1]中国能源电力发展展望2020[R].北京.国家电网国网能源研究院2020.

[2]钟景华,傅烈虎.新基建:数据中心规划与设计[M].北京.电子工业出版社2021.

[3]中国通信标准化协会开放数据中心标准推进委员会.冷板式液冷M.北京.化学工业出版社,2019.

[4]英特尔至强Platinum处理器[M].英特尔公司.2021.

[5]DatacomEquipmentPowerTrendsandCoolingApplica?tions,3rdEdition[M].ASHRAE.2018.

[6]T/CCSA269-2019,数据中心液冷服务器系统总体技术要求和测试方法[S]冲国通信标准化协会,2019.

[7]清华大学气候变化与可持续发展研究院.读懂碳中和[M].中信岀版集团2021.118.