官网:https://openai.com/blog/chatgpt/

Methods

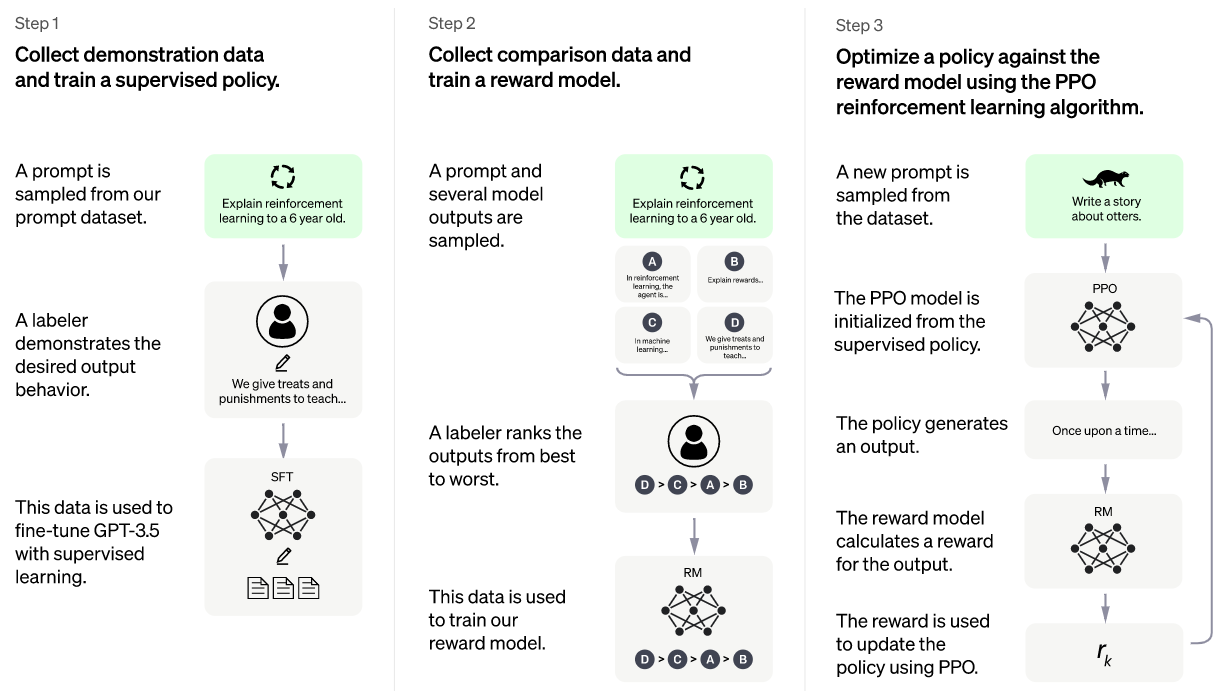

我们使用来自人类反馈的强化学习(RLHF)来训练这个模型,使用与InstructionGPT相同的方法,但数据收集设置略有不同。我们使用有监督的微调训练了一个初始模型:人工智能训练师提供对话,他们扮演用户和人工智能助手的双方角色。我们让训练师获得模型书面建议,以帮助他们撰写回复。我们将这个新的对话数据集与InstructGPT数据集混合,并将其转换为对话格式。

为了创建强化学习的奖励模型,我们需要收集比较数据,其中包括两个或多个按质量排序的模型响应。为了收集这些数据,我们进行了AI训练师与聊天机器人的对话。我们随机选择了一个模型撰写的消息,抽样了几个备选的完成,并让AI训练师对其进行排名。使用这些奖励模型,我们可以使用近端策略优化(PPO)对模型进行微调。我们对这个过程进行了多次迭代。

ChatGPT从GPT-3.5系列中的一个模型进行了微调,该系列于2022年初完成了训练。您可以在此处了解有关3.5系列的更多信息。ChatGPT和GPT 3.5在Azure AI超级计算基础设施上进行了训练。

Limitations

- ChatGPT有时会写出看似合理但不正确或荒谬的答案。解决这一问题具有挑战性,因为:(1)在RL训练期间,目前没有任何真相来源;(2) 训练模型更加谨慎会导致它拒绝正确回答的问题;(3)监督训练误导了模型,因为理想的答案取决于模型知道什么,而不是人类演示者知道什么。

- ChatGPT对输入短语的调整或多次尝试同一提示很敏感。例如,给定一个问题的一个短语,模型可以声称不知道答案,但稍微重新措辞,可以正确回答。

- 该模型通常过于冗长,过度使用某些短语,例如重申它是OpenAI训练的语言模型。这些问题源于训练数据中的偏差(训练师更喜欢看起来更全面的较长答案)和众所周知的优化问题。1,2

- 理想情况下,当用户提供模棱两可的查询时,模型会提出明确的问题。相反,我们当前的模型通常猜测用户的意图。虽然我们努力让模型拒绝不适当的请求,但它有时会响应有害的指令或表现出有偏见的行为。

- 我们正在使用Moderation API来警告或阻止某些类型的不安全内容,但我们预计目前它会有一些误报和误报。我们渴望收集用户反馈,以帮助我们正在进行的改进系统的工作。